Impressie van de bijeenkomst van het Filosofisch Café Haarlem op 20 november 2024

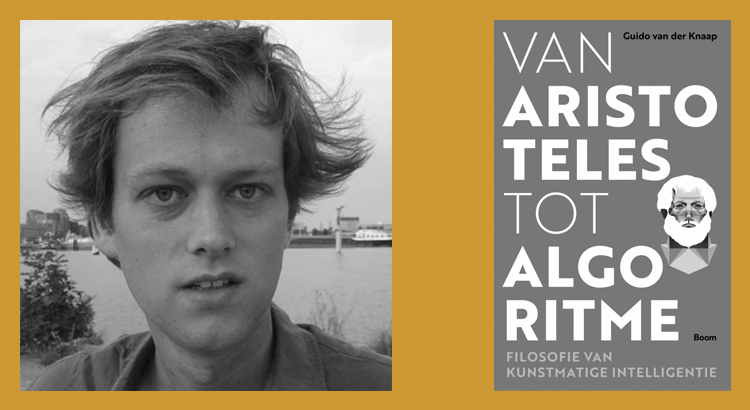

Op deze avond hield Guido van der Knaap voor 75 aanwezigen een inleiding over zijn boek Van Aristoteles tot algoritme. Filosofie van kunstmatige intelligentie.

Guido van der Knaap (1991) studeerde wijsbegeerte, logica en politicologie aan de Universiteit van Amsterdam en werkt daar als docent bij de opleiding

kunstmatige intelligentie. Het boek Van Aristoteles tot algoritme is zijn debuut en stond al direct op de shortlist van de Socratesbeker 2023.

Guido van der Knaap begon zijn inleiding met de titel, AI – van alziend tot alwetend?, met de vraag wie er allemaal AI gebruikt. Zo’n 85% van de aanwezigen stak zijn hand op. Guido gaf aan dat dit een hoge score is maar niet zo hoog als de 100% score bij zijn presentatie voor de studenten van de Wageningen University.

Guido gaf aan dat het ook mooi was dat hij zijn inleiding in Haarlem kon houden, de stad met de koepelgevangenis naar het panopticumontwerp van Jeremy Bentham (1748-1832). Met dit ontwerp kan één bewaker in de centrale toren alle gevangen controleren. De gevangen zitten in hun individuele cellen, kunnen niet met elkaar communiceren en hebben alleen zicht op de toren met de bewaker. Zij weten niet of er een bewaker in de toren zit, maar de illusie is voldoende om te zorgen dat zij zich goed gedragen. Dit concept is: Kijken zonder bekeken te worden.

Michel Foucault (1926-1984) beschrijft later hoe het panopticum kenmerkend is voor de samenleving zoals die zich in de 19e en 20ste eeuw ontvouwt. De disciplinerende macht van koningen en ridders die dit met hun aanwezigheid en met hun zwaard afdwingen wordt vervangen door andere vormen van disciplinering. Bij deze nieuw disciplinaire macht gaat het om normalisatie, bijvoorbeeld de gevangenen in hun cel, de leerlingen op vaste plaatsen in de klas, de dienstplichtigen in het gelid et cetera. Door de permanente zichtbaarheid functioneert de macht automatisch.

Michel Foucault geeft aan dat deze vorm van macht niet is om te straffen, te ontnemen of te onttrekken, maar om te “dresseren”. Dit dresseren begint al op school en gaat later door in het werkzame leven en heeft tot doel dat de kapitalist in staat is om beter de meerwaarde van de productie van de arbeiders te onttrekken, meer te kunnen ontnemen.

Waren de koepelgevangenis van Bentham en de dressuur van Foucault nog aan specifieke plaatsen gebonden, de dia met de Chinese politieagenten met een Google-bril met gezichtsherkenning in Xinjiang, laat zien dat dat tegenwoordig niet meer nodig is. De NOS: “Op een gemiddelde straathoek is het aantal camera’s met gezichtsherkenning niet op twee handen te tellen”. De New York Times: “Ook buiten de regio Xinjiang herkennen camera’s Oeigoeren”. De organisatie Human Right Watch noemt dit: “Misdaden tegen de menselijkheid”. Die camera’s zijn onderdeel van een repressief systeem. Als er op een bepaalde locatie meer Oeigoeren zijn dan normaal dan gaat het alarm af en treedt de politie op.

In China hangen nu zo’n 400 miljoen camera’s met gezichtsherkenning in de openbare ruimte. De onderzoeksjournalist Hu Liu gaf al in 2021 bij de BBC aan dat hij van de lift in zijn appartement tot in het café in het zicht van de (AI)-camera’s is.

“Once you leave home and step into the lift, you are captured by a camera. There are cameras everywhere. When I leave home to go somewhere, I call a taxi, the taxi company uploads the data to the government. I may then go to a cafe to meet a few friends, and the authorities know my location through the camera in the cafe. There have been occasions when I have met some friends and soon after someone from the government contacts me. They warned me, ‘Don’t see that person, don’t do this and that.’ With artificial intelligence we have nowhere to hide.”

Foucault noemt dit ‘veiligheidstechnieken’, het gaat om het bekijken van de volledige bevolking. Uitgangspunt is het in stand houden van de ‘normale’ situatie. Wat normaal is volgt uit de bevolkingsgegevens (b.v. stijging van de criminaliteit, meer Oeigoeren dan normaal). Maar: het zijn veelal specifieke groepen (minderheden) die de knoet van de technologische vooruitgang voelen.

Met een dia van Robert Williams, een zwarte man uit Detroit, laat Guido het eerste gedocumenteerde geval in de VS zien van een persoon die onterecht werd vastgehouden op basis van gezichtsherkenningstechnologie. Er zijn meerdere voorbeelden van het slecht werken van gezichtsherkenning bij zwarte mensen. Amazon gebruikt camera’s in de bussen van hun bezorgers om de veiligheid te verbeteren: boetes bij het niet dragen van de veiligheidsgordel en een verplichte pauze van 15 minuten bij geeuwen.

Ook in Roermond gebruikte de politie in de periode 2018 – 2020 camera’s met gezicht- en nummerbordherkenning die, gekoppeld aan grote hoeveelheden data en algoritmes, winkeldiefstallen en zakkenrollerij moesten voorspellen in de Designer Outlet Roermond. Het algoritme kende een hogere kans toe aan nummerborden uit Oost Europese landen en van Duitse huurauto’s. En ook onschuldig staande gehouden auto’s kregen een grotere kans om de volgende keer weer staande gehouden te worden. Amnesty: “Iedereen die in en rond Roermond in de auto zit, is een levend proefkonijn”.

De opkomst van AI rust op drie pijlers:

- Methoden: Deep Learning, statistische relaties tussen plaatjes

- Data: Digitalisering van bibliotheken, social media, browsegedrag, camerabeelden

- Rekenkracht: groeide vanaf 2010 met een factor vier tot vijf per jaar

Waar Deep Blue, die in 1997 Garry Kasparov met schaken versloeg, nog werd geprogrammeerd met strategieën van grootmeesters, werd AlphaGo-Zero een zelflerend programma dat na 29 miljoen oefenpotjes in staat was om in 2017 de Chinese grootmeester Ke Jie te verslaan.

Met het zelflerend programmeren van AlphaGo raken we aan John Locke (1632-1704): de menselijke geest is een tabula rasa, een onbeschreven blad. Zonder kennis, vaardigheid en persoonlijkheid – en volledig afhankelijk zijn van waarneming en ervaring om de geest te vormen.

In de geschiedenis zijn er twee stromingen te onderkennen:

- Thomas Hobbes (1588-1679): Rationeel denken is hetzelfde als rekenen, het optellen en aftrekken van deeltjes in het brein. De zogenaamde mechanische benadering van het denken.

- René Descartes (1596-1650): Machines handelen niet uit inzicht, ‘maar uitsluitend door hun mechaniek’. Machines hebben niet een door God gegeven ziel en zullen altijd tekort schieten.

Deze tweedeling is nog steeds aanwezig.

Omdat AI net zo ‘goed’ is als de data waarop het is getraind, reflecteert AI de data waarop het is getraind. Een bias ofwel een fout of een afwijking van de werkelijkheid in de gebruikte data leidt dus tot fouten, afwijkingen bij de uitkomst.

Bij een oefening waar gevraagd werd om het ontbrekende zinsdeel in te vullen, vulde GPT-3 in 66 van de 100 gevallen een zinsdeel over twee moslims die ergens binnenliepen, aan met een gewelddadige component zoals schieten of moorden. En in 23 procent van de gevallen kiest het ‘terrorist’ als analogie voor ‘moslim’.

En enkele jaren geleden koppelde Amazon Rekognition bijna een zesde van 188 bekende atleten uit Massachusetts aan een database van arrestanten. Een gevolg van de combinatie van veel zwarte atleten en slecht werkende gezichtsherkenning bij zwarte mensen.

Aan het programma Stable Diffusion werd in 2023 gevraagd om fotoafbeeldingen te maken van de uitoefenaars van verschillende beroepen. Beoordeeld werd of er een verschil was tussen het aantal mannelijke en vrouwelijke gegeneerde afbeeldingen en de Amerikaanse werkelijkheid. Bij beroepen als bordenwasser en kassamedewerker genereerde het programma significant meer vrouwen dan de werkelijkheid en bij beroepen als doctor en rechter juist veel minder.

Google Gemini probeerde de man-vrouw en de culturele bias in de data te compenseren, maar dat leidde weer tot plaatjes van Aziatische vrouwen en zwarte mannen in het Duitse leger van 1943 en inheemse en zwarte senatoren in de senaat van Amerika in 1800. Kortom er is geen eenvoudige oplossing voor de bias in de data en in de resultaten.

Een goede data-labeling kan voor verbetering zorgen en daarom werken Keniaanse arbeiders voor minder dan twee dollar per uur om ChatGPT minder ‘toxic’ te maken. Een vorm van neokolonialisme. Oftewel: het ‘succes’ van AI is ook (groten)deels mensenwerk, en dan vooral mensenwerk in de Global South ‘onder de meest schrijnende omstandigheden’.

Tijdens de coronaperiode in de zomer van 2020 wilde een school in Engeland het docentadvies voor de score van leerlingen door een algoritme definitief laten bepalen. Hier kwam een groot protest tegen want dat zou betekenen dat de postcode bepalender zou zijn dan de cijfers. Leerlingen uit achterstandswijken zouden hiervan de dupe worden. De leerlingen worden gereduceerd tot data.

In navolging van het boek van Dick Swaab uit 2012, Wij zijn ons brein, zou je nu kunnen zeggen “Wij zijn onze data”.

AI is getraind op het werk van o.a. schrijvers, schilders, muzikanten en journalisten. Maar deze kunstenaars en denkers hebben hier nooit toestemming voor gegeven. Deze bedrijven gaan dus met de ideeën en creativiteit aan de haal zonder copyright te betalen. Want AI produceert nieuwe content, die ook nog overeenkomsten kan vertonen met bestaand werk. Dit is een serieus probleem voor huidige en toekomstige kunstenaars en hun auteursrechtenorganisaties maken zich hier dan ook terecht boos over.

Een trainingssessie van GPT-3 stootte 552,1 ton CO2 uit, ongeveer het equivalent van 400 vluchten van Amsterdam naar Los Angeles. Servers van ChatGPT gebruiken dagelijks net zo veel energie als 34.000 Nederlandse huishoudens (schatting). Zowel het trainen van AI-modellen als de werking ervan kost (veel) energie. Nu al zijn data-centra verantwoordelijk voor 1% van de wereldwijde CO2 uitstoot. Dit gaat de komende jaren verder stijgen. Krijgen we na vliegschaamte nu ook een dataschaamte?

Ongeacht de nu al bekende nadelen lijken wij in de ban van AI. “Dit is toch magisch” (Tech-expert Jarno Duursma), van de studenten in 2022 gebruikte 95,3% ChatGPT en Mc Kinsey: AI kan bedrijfswinsten jaarlijks met 4,4 miljard dollar doen toenemen.

De verwachtingen zijn hooggespannen maar sommige zaken lijken voor AI onbereikbaar, zoals:

- De wijsheid om goed te handelen in de geest van de Ethica van Aristoteles

- Het begrijpen hoe onze emoties, ervaringen en opvoeding bijdragen aan onze ontwikkeling tot een moreel wijs persoon met de bijbehorende vaste, innerlijke houding

- Zintuigelijke ervaringen zoals smaak of pijn

Leidt AI tot de industrialisering van het denken? Gaan we alles ‘berekenen’? Laten we ook essays schrijven door AI en afbeeldingen produceren? Dat lijkt ‘Onttovering 2.0’. Het begrip onttovering is van Max Weber (1864 – 1920) die in 1904 De onttovering van de wereld schreef. Hiermee duidde hij het proces van rationalisering aan waarbij gepoogd wordt om praktische problemen niet meer met magie maar met technologie op te lossen. Max Weber noemde dit concept de ‘ijzeren kooi’ die individuen gevangen houdt in systemen die puur gebaseerd zijn op teleologische efficiëntie, rationele berekening en controle. Weber beschreef de bureaucratisering van de sociale orde ook als “de poolnacht van ijzige duisternis”.

Guido sloot zijn inleiding af met de conclusie dat wij net als Sisyphus voortdurend zelf het rotsblok omhoog moeten duwen. En dan ook nog voortdurend AI in de gaten houden. Hopelijk helpt Albert Camus (1913 – 1960) ons en is de strijd om met het rotsblok de top van de berg te bereiken voldoende om ons hart te vullen en een gelukkig mens te worden.

Na de pauze startte de dialoog.

Of beter gezegd barstte het spervuur van vragen en antwoorden los, dat hierna wordt weergeven met Q en A:

Q: Werkt de gezichtsherkenning nog wel als de demonstranten maskers opzetten?

A: Nee en daarom werd er in Hong Kong in 2019 met maskers, helmen en paraplu’s gedemonstreerd tegen de Chinese regering. Het risico op forse straffen was en is zeer reëel.

Q: Als AI zelf muziek en kunst maakt en deze data weer gebruikt om zichzelf te trainen krijg je dan niet een digitale inteelt?

A: Ja, als AI niet in staat is om AI gegenereerde data te herkennen dan zal de ontwikkeling niet verder komen. Alsof je 5 VWO moet doen met boeken van 4 VWO.

Q: Kan AI ziek worden of zich depressief voelen?

A: Nee, maar een chatbot zou dit wel kunnen imiteren.

Q: Kan je AI ziek maken door foute data in te voeren?

A: Nee, AI heeft geen moreel bewustzijn.

Q: Als ik een opdracht geef van “schrijf een boek” van wie is dan het copyright?

A: Dat is een lopende discussie. Aanvulling uit de zaal: Je mag het wel gebruiken maar het copyright blijft bij de eigenaar(s).

Q: Als AI kunst maakt dan zal de vernieuwing en het aantal kunstenaars toch afnemen?

A: Vernieuwing wordt lastig maar met kunstenaars die AI als instrument gebruiken kan de vernieuwing op die wijze wel weer toenemen.

Q: Maken zelfrijdende auto’s morele afwegingen; redden ze de voetgangers of de bestuurder?

A: Het bedrijf maakt de keuze in het ontwerp maar of ze alle bijzondere situaties kunnen inprogrammeren, zoals overstekende gekke koeien, lijkt mij niet.

Q: Tegenwoordig zijn er veel factcheckers actief die waarheid van verzinsel onderscheiden. Kan AI daarbij helpen?

A: Bar weinig want het is niet zo makkelijk te programmeren; het vereist nu veel interpretatie door echte onderzoekers. Er is nu wel een chatbot geprogrammeerd om complotdenkers te heropvoeden.

Q: Kan AI het met zichzelf oneens zijn?

A: Nee, de totstandkoming van de output is volkomen intransparant. Het is geen reguliere paper met noten. Wel zijn sommige AI programma’s geprogrammeerd om minder stellig te formuleren, een slag om de arm te houden.

Q: Je hoort dat sommige mensen liefdesrelaties met AI aangaan. Is dit de toekomst?

A: Lastige vraag, intuïtief denk ik dat dit tot een klein groepje beperkt blijft. Op vakantie heb ik soms met Google Translate gecommuniceerd. Daar ben ik snel klaar mee.

Q: Waarom gebruikt u weinig AI?

A: Ik gebruik weinig generatieve AI want ik ben wetenschapper en vind het daarbij niet passen. Ook denk ik dat ik mijn mail sneller zonder dan met AI kan beantwoorden.

Q: Stephen Hawking heeft gewaarschuwd voor de gevaren van AI. Het kan het beste, maar ook het slechtste zijn wat de mensheid ooit is overkomen. Hij voorziet zelfs de ondergang van de mensheid. In het beste geval wordt de mens een werkmier, die wordt aangestuurd door hele slimme robots.

A: Zulke uitspraken leiden de aandacht af van de echte problemen en dat is de macht van grote techbedrijven.

Q: Wat zou Aristoteles van AI hebben gevonden?

A: Aristoteles was ook een religieus denker en zou AI sceptisch hebben benaderd want het impliceert dat de mens een God zou zijn geworden.

Q: Wat zei Aristoteles over de wijsheid en de waardigheid

A: Bij Aristoteles is het verkrijgen van wijsheid en waardigheid een wordingsproces, iets wat door studie en herhaling van het goede gedrag verkregen kan worden. Dat is niet haalbaar voor AI.

Q: Kan je menselijke ervaringen aan AI geven?

A: Nee dat kan niet. Denk maar over de sensatie van het inademen van zeelucht of sterfelijkheid. Ook de intentionaliteit van de geest is voor AI niet te evenaren.

Q: AI is niet nieuw dat was er vroeger ook al maar nu is het alom aanwezig. Dat roept bij mij de vraag op wie wij zelf zijn of hoe moeten wij ons als mens tot AI verhouden?

A: Dat moet iedereen zelf weten, ik ben terughoudend.

Q: Voor mij is AI alleen maar kunstmatig dus laat die “I” maar weg. Ik ben wel bang voor het gebruik van AI.

A: Het is inderdaad Ai met een kleine “i“. Het is niet echt intelligent maar wel zo inzetbaar en als het vaak wordt toegepast dan wordt dat de norm.

Q: Is AI in staat om het verschil te zien in goed en fout in morele zin?

A: Moeilijk, er lopen nu wel experimenten met toepassingen in de rechtspraak.

Q: Wat is het nut van AI?

A: Er is een stroming die met AI de werking van het menselijk brein wil imiteren maar het belangrijkste nut is geld verdienen.

Q: Ik maak me zorgen want de wereld wordt ingewikkelder, AI versnelt dit en we staan pas aan het begin van deze ontwikkeling.

A: De verwachting was ook dat we een enorme overvloed zouden krijgen aan Fake News en Fake Video’s, dat is niet uitgekomen. De toekomstverwachtingen van AI worden nogal overdreven, een grote teleurstelling is volgens mij heel goed mogelijk.

Q: Bestaan er ook sabotageprojecten door AI op basis van foute data invoer?

A: In ieder geval niet bewust door de grote techbedrijven. Maar je kan natuurlijk de Metroman AI Chatbot voeden met foute trainingsdata van rabbitAI en dan krijg je gekke antwoorden.

Q: Als AI verkeerd wordt ingezet dan krijgen we een nare maatschappij. Kunnen we dan in opstand komen en de stekker eruit trekken?

A: Nee dan zal AI dit al drie stappen eerder zien aankomen en voorkomen. Het is net zo moeilijk als het vermoorden van Poetin.

Hanno de Groot bedankte Guido van der Knaap voor zijn inleiding in de wereld van de AI en beantwoording van het spervuur aan vragen. Onder groot applaus werd de avond afgesloten.

Gerrit van Elburg